ディープなウェブを意識しよう

2007年10月11日

(これまでの 関裕司の「サーチ・リテラシー」はこちら)

GoogleやYahoo!のようなサーチエンジンは、私たちがウェブで見ることのできる情報のうちどの程度をカバーしているだろうか。両者とも現在はインデックスサイズを公表していないが、おそらく数百億ページというオーダーになるだろう。これはウェブ全体の何割を占めているのだろうか。8割くらいだろうか、それとも5割もないのだろうか。実は1%もないんじゃないかと私は思っている。

実際のところ、私たちが通常のサーチエンジンで到達できる部分は広大な情報の海の表面にしかすぎない。しかもその海の表面は荒れている場所もあればウソに染まった部分もある。では信頼のおける確かな情報はどこにあるのか。それは海の表面ではなく奥深くの部分、「見えないウェブ(invisible web)」または「ディープウェブ(deep web)」と呼ばれる領域である。ではなぜサーチエンジンはこのディープな部分を検索できないのか。理由は簡単で、サーチエンジンの情報収集エージェントであるクローラーは海に潜れないのだ。クローラーはリンクによってつながっているページであれば、どこにでも出かけていくことができる。ところが「リンクされていない情報」がウェブ上に大量にあることにみなさんは気づいているだろうか。

簡単な例を示そう。ウェブで頻繁に使われるサービスに「辞書」がある。私の最もお気に入りの辞書はスペースアルクで提供されている「英辞郎 on the Web」だ。例文が豊富なので表現辞典としても使うことができる。私たちがこういった辞書を使うときの動作を思い出してみよう。リンクをクリックしながら言葉の意味を調べているだろうか。いや、そうではなくて、単語を「入力」してから検索ボタンをクリックしている。そうするとバックエンドで控えている辞書のデータベースに問い合わせを行い、得られた結果を整形してHTMLのページとして私たちに見せてくれる。人間にとっては何のことはないこの一連の動作を、サーチエンジンのクローラーは決してすることができないのだ。

このようなデータベースと連動して表示される動的なページを提供しているサイトは多数ある。しかもその多くは公的な機関の資料であったり、学術性、専門性の高いコンテンツであったりする。信頼性という点ではクローラーが巡回できる荒れて汚れた海の表面とはまったくレベルが違うのだ。だから、本当の情報収集の能力というものは、このディープウェブというものを常に意識しているかどうかにかかっているのだ。

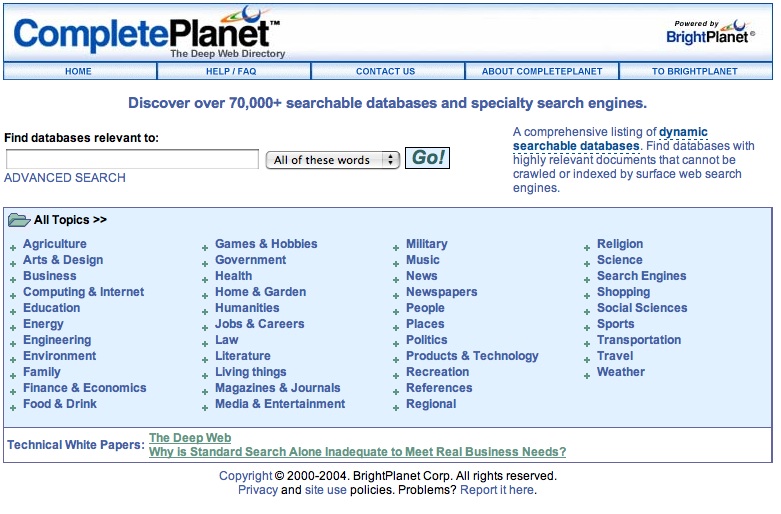

もちろん、個々人があらゆるディープウェブに精通することはできない。しかしその道案内さえあればいいのだ。海外では例えば「CompletePlanet」は70,000以上のディープウェブなサイトのディレクトリーを構築している。ところが日本ではこれまでディープウェブという切り口で語られることがあまりなかったせいか、ここまで本格的なサイトは見たことがない。Googleのミッションは「世界中の情報を体系化し、アクセス可能で有益なものにすること」らしいが、さて、Googleに期待してよいものだろうか。あるいは国の予算で動いている「情報大航海プロジェクト」が次世代検索技術云々などといって大後悔プロジェクトとなるよりは、この地味ではあるが有用なディープウェブ対策をやっていただいた方がずっと世の中のためになると思うのだが、どうだろうか。

関裕司の「サーチ・リテラシー」

過去の記事

- 懐かしいあのサイトを再訪2007年12月20日

- ブックマークしておきたい辞書サイト2007年12月13日

- Twitter検索でゆるやかな嗜好のつながりを作る2007年11月 8日

- ヤフーのfeatureオペレータとは2007年11月 1日

- 未来のウェブサービスに流されないぞ宣言2007年10月25日